Na última década, a cultura DevOps revolucionou a forma como construímos e entregamos software. Ferramentas como CI/CD, Infraestrutura como Código (IaC) e monitoramento avançado nos deram uma velocidade e estabilidade que antes pareciam impossíveis. No entanto, essa velocidade gerou uma nova ordem de complexidade. Nossos sistemas, agora distribuídos em microsserviços, rodando em nuvens híbridas e gerando terabytes de logs e métricas, estão se tornando complexos demais para a cognição humana gerenciar sozinha. Estamos nos afogando em dados e alertas, e a automação que criamos, embora poderosa, é fundamentalmente prescritiva: ela só faz exatamente o que mandamos.

Mas e se a automação pudesse evoluir? E se, em vez de apenas executar nossos scripts, ela pudesse entender nossos objetivos, analisar o dilúvio de dados e decidir o melhor curso de ação… de forma autônoma?

Bem-vindo à era dos AI Agents, a força que está prestes a transformar o DevOps de dentro para fora.

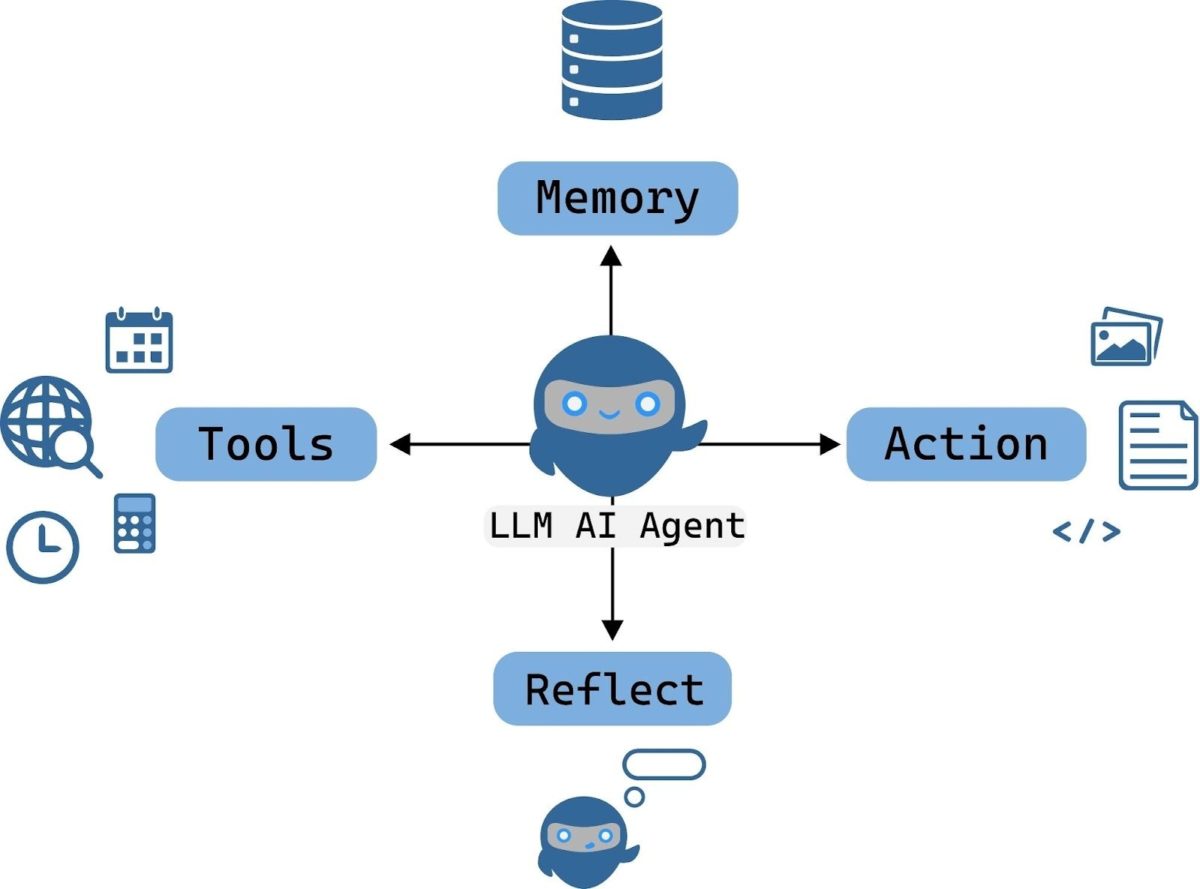

O que são, exatamente, os AI Agents?

Primeiro, vamos esclarecer: um AI Agent não é simplesmente um chatbot. Um chatbot (como o ChatGPT) é reativo; ele responde às suas perguntas com informações. Um Agente de IA, por outro lado, é um sistema autônomo que pode perceber seu ambiente, planejar uma sequência de ações para atingir um objetivo complexo e, crucialmente, agir sobre esse ambiente usando um conjunto de ferramentas.

Pense na arquitetura básica de um agente:

- Percepção: são os “sentidos” do agente. Ele se conecta a fontes de dados como logs (Splunk, ELK), métricas (Prometheus, Datadog), alertas (PagerDuty) e até mesmo código (GitHub).

- Planejamento (Deliberação): este é o “cérebro”. Usando um Modelo de Linguagem Grande (LLM) como o GPT-4 ou o Claude 3, o agente quebra um objetivo complexo (ex: “O serviço de login está lento”) em uma lista de etapas executáveis (ex: “1. Verificar logs de latência. 2. Analisar métricas do pod. 3. Identificar gargalo. 4. Se for o banco de dados, escalar réplicas.”).

- Ação: são as “mãos” do agente. Ele tem permissão para usar “ferramentas”, que nada mais são do que APIs. Essas ferramentas podem ser kubectl para gerenciar o Kubernetes, a API da AWS para provisionar infraestrutura, um cliente do Slack para enviar mensagens, ou um comando git para abrir um Pull Request.

- Memória: o agente lembra o que fez, o resultado de suas ações e o contexto da conversa, permitindo que ele execute tarefas de vários passos sem se perder.

A Evolução: de chatbots reativos a agentes proativos

A jornada da automação em operações tem sido uma escada de autonomia crescente.

- Nível 1: Chatbot (Informativo): você pergunta no Slack: “Qual o status do deploy 123?” O bot consulta uma API e responde: “Status: Concluído.”

- Nível 2: ChatOps (Prescritivo): você comanda no Slack: “/deploy-prod-frontend-124”. O bot executa um pipeline de CI/CD pré-definido que você escreveu. Ele é um executor de tarefas, mas não toma decisões.

- Nível 3: AI Agent (Autônomo): você diz ao agente: “Nossa fatura de nuvem está muito alta este mês. Investigue e otimize nossos custos na AWS.”

O Agente, então, inicia um processo:

- Plano: “Preciso analisar os custos por serviço. Vou usar a API do AWS Cost Explorer.”

- Ação (Ferramenta): executa a chamada de API.

- Percepção: “Os dados mostram que 40% do custo vem de instâncias EC2 ‘t3.xlarge’ no ambiente de staging que estão 90% ociosas fora do horário comercial.”

- Plano: “Vou criar um script para desligar essas instâncias às 18h e ligá-las às 8h. Antes disso, vou verificar se há algum ‘lock’ de deploy.”

- Ação (Ferramenta): consulta a API do Jenkins/GitLab. “Nenhum deploy agendado.”

- Ação (Ferramenta): aplica a nova política de auto-scaling ou shutdown.

- Ação (Ferramenta): envia uma mensagem no Slack: “Otimizei os custos de staging, economizando uma projeção de R$ X por mês, desligando instâncias ociosas. Nenhuma ação humana necessária.”

Este é o salto: de um executor de comandos para um solucionador de problemas.

O Ponto de Virada: AI Agents no coração do DevOps (AIOps 2.0)

O DevOps nos deu os pipelines; os AI Agents nos darão os motoristas autônomos para esses pipelines. Veja como isso se aplica diretamente às dores de um time de SRE/DevOps:

- Otimização Autônoma de Custos (FinOps)

- Hoje (Análise): você exporta um CSV, faz uma tabela dinâmica no Excel e sugere que o time X reduza o tamanho de uma instância.

- Amanhã (Agente): o Agente monitora os dados do AWS Trusted Advisor e as métricas do Prometheus em tempo real. Ele detecta um serviço superprovisionado, calcula o downsize ideal que não viola os SLOs, gera o Pull Request no Terraform (IaC) com a alteração, e o marca para aprovação humana.

- Otimização de Performance e Qualidade de Código

- Hoje (Análise): o SonarQube falha no pipeline por “Code Smell”. Um engenheiro sênior precisa revisar o PR e sugerir a correção.

- Amanhã (Agente): um Agente de “Code Review” é acionado no PR. Ele não apenas aponta o “Code Smell”, mas entende o contexto do código e sugere a refatoração exata como um comentário no GitHub, explicando por que a nova versão é mais performática ou segura.

- Otimização de Pipeline (CI/CD)

- Hoje (Análise): o time percebe que o CI está lento (20 min). Um engenheiro gasta uma tarde investigando e descobre que os testes de integração estão rodando em série.

- Amanhã (Agente): o Agente monitora as métricas do pipeline. Ele detecta o gargalo e reescreve o arquivo gitlab-ci.yml ou Jenkinsfile, propondo uma nova configuração com testes paralelizados para acelerar o build, e abre um PR com essa otimização.

- Remediação Autônoma de Incidentes (AIOps)

Este é o Santo Graal.

- Hoje (ChatOps): 3h da manhã. O PagerDuty acorda o SRE. O alerta diz “Latência alta no serviço de checkout”. O SRE levanta, abre o notebook, consulta os logs, vê que um pod está em CrashLoopBackOff, reinicia o pod e volta a dormir.

- Amanhã (Agente): 3h da manhã. O PagerDuty aciona o AI Agent.

- Agente (Percebe): “Alerta de latência.”

- Agente (Planeja): “Vou verificar os serviços dependentes. Vou verificar os logs dos pods.”

- Agente (Age): consulta o Datadog. “Métricas de CPU e Memória normais.” Consulta o Splunk. “Logs do ‘checkout-pod-7d7d…’ mostram OOMKilled.”

- Agente (Planeja): “Incidente claro. Um pod está sem memória. Ação de remediação imediata: reiniciar o pod. Ação de longo prazo: verificar o ‘commit’ que causou o ‘memory leak’.”

- Agente (Age): executa kubectl rollout restart deployment/checkout-service.

- Agente (Percebe): “Latência normalizada.”

Agente (Age): Atualiza o ticket do PagerDuty: “Incidente resolvido. Causa raiz identificada como OOMKilled no checkout-service. O deploy foi reiniciado automaticamente. Nenhuma ação humana foi necessária.”

O SRE nem sequer acordou.

Frameworks e ferramentas para começar

Construir esses agentes está se tornando cada vez mais acessível graças a frameworks de código aberto:

- LangChain (Python/JS) / LangChain4j (Java): o “canivete suíço” para construir aplicações com LLMs. Ele fornece os blocos de construção para conectar LLMs a fontes de dados (Percepção) e ferramentas (Ação).

- LlamaIndex: focado em criar a “Memória” do agente, permitindo que ele ingira e consulte grandes volumes de documentação, bases de código ou logs.

- AutoGen (Microsoft): um framework fascinante focado em criar múltiplos agentes que colaboram entre si para resolver uma tarefa. Você pode ter um agente “Engenheiro” que escreve o código, um agente “QA” que escreve os testes, e um agente “Gerente” que coordena os dois.

- Plataformas de AIOps (Datadog, Dynatrace): essas plataformas já estão embutindo seus próprios agentes (como o Datadog Bits) para analisar incidentes e sugerir causas-raiz, diminuindo a fronteira entre monitoramento e ação.

Benefícios Empresariais: o que realmente muda?

Quando os Agentes de IA são integrados ao DevOps, os benefícios vão muito além da conveniência.

- Redução Drástica do MTTR (Mean Time to Resolution): incidentes são resolvidos em segundos, não em horas.

- Liberação de Capital Humano: seus engenheiros mais seniores, que hoje gastam tempo “apagando incêndios”, são liberados para focar no que realmente importa: inovar, arquitetar novos sistemas e fazer mentorias.

- Operações 24/7 Reais: a automação autônoma não se cansa, não comete erros por fadiga e escala instantaneamente.

- Sistema de Melhoria Contínua: os agentes podem ser programados para não apenas corrigir problemas, mas para aprender com eles e propor melhorias estruturais (como otimizar o código ou a infraestrutura) para que o problema nunca mais ocorra.

Conclusão: de Engenheiro de DevOps para Supervisor de Agentes

Os AI Agents não vêm para substituir a cultura DevOps e sim para completá-la. Eles são a ferramenta que finalmente nos permitirá cumprir a promessa de operações verdadeiramente ágeis e resilientes em sistemas de alta complexidade. A mudança de paradigma é sutil, mas profunda: como engenheiros, nosso trabalho passará cada vez menos de escrever scripts prescritivos para nos tornarmos supervisores de agentes autônomos. Nosso foco será em definir os objetivos corretos (SLOs), curar as ferramentas (APIs) que eles podem usar e garantir que eles ajam de forma segura e eficiente. A era da automação está dando lugar à era da autonomia.

Pronto para dar o passo definitivo para a evolução da IA e da Automação?

Então conheça as Soluções de Consultoria de IA da DBC!